Pixie, arxiv preprint 2025

Pixie, arxiv preprint 2025

Abstract

- 태스크: 3D scene의 물리적 특성 복원

- Novel method that trains a generalizable neural network to predict physical properties across multiple scenes from 3D visual features purely using supervised losses

- 학습시키고 나면, 우리의 feed-forward network는 빠르고 정확하게 “material fields”를 추론할 수 있다

- 가우시안 스플래팅으로 표현된 정적인 static scene을 현실적으로 물리기반 시뮬레이션하는 scene으로 변형 가능

- PixieVerse 데이터셋 ⇒ 3D assets + physical material annotation포함

- CLIP같은 pretrained visual features 활용해서 zero-shot일반화

- real-world scene + synthetic data(이게 더 학습되나봄)

Introduction

- NeRF + 3DGS ⇒ learning-based scene reconstruction 네트워크

- sparse camera 뷰로부터 3D geometry와 장면을 사실적으로 복원할 수 있음

- visual appearance에만 집중해서 표현함

- geoemtry와 scene의 color만

- physical properties 부재함

- 기존 3D scnee의 physical properties복원의 메소드를 크게 두가지로 분류됨

- 사용자가 도메인 지식을 바탕으로 장면 전체에 대한 재질 파라미터를 직접 지정하도록 요구(?)

- 테스트 시점 최적화(test-time optimization)를 통해 재질 추출 과정을 자동화

- PIXIE : geometry + appearance + physical learning 통합해서 예측

- PixieVerse 데이터 : 1,624개의 paired 3D objects & annotated materials

- spanning 10 semantic classes

Contributions

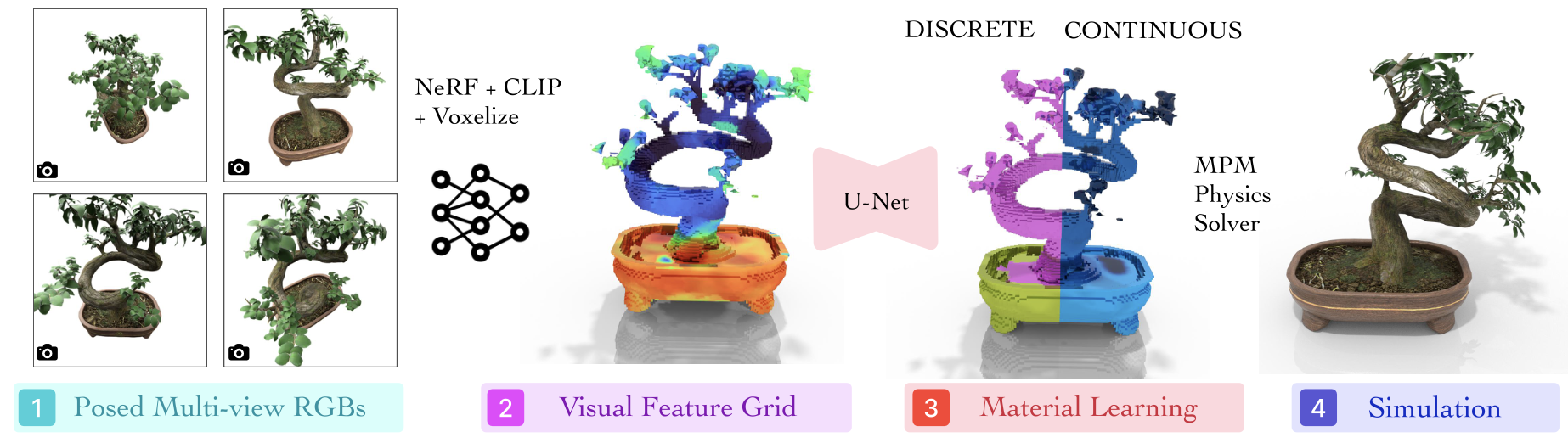

- 3D Physics Prediction에서의 새로운 프레임워크 제안

- 이산적인 물질의 타입을 예측 &

- 연속적인 physical parameter (Young’s modulus, Poisson’s ratio, density)를 예측

- PIXIEVERSE 데이터셋 제안

- 3D objects (from Objaverse) + physical material annotations 제공

- 1624종류의 물체 + 10개의 semantic한 클래스

- Inference가 빠르고 generalizable함

- CLIP의 pretrained visual feature와 3D U-Net의 feed-forward활용하여 빠른 테스트타임 최적화

- Real scene에서의 zero-shot generalization 성능

- 합성데이터로만 학습함에도 ㅂ루구하고, real-world scene에 잘 작동함

- sim-to-real gap완화

- MPM(material point-method) Solver와 함께 Seamless integration 성능

- 물리 시뮬레이션을 위해, 예측된 material field는 Gaussian Splatting모델이랑 같이 합쳐져서 렌더링될 수 있음 ⇒ wind, gravity같은 애니메이션

Method

- 기본 논지: 3D 시각적 외형(기존 NeRF와 3DGS같은 뉴럴렌더링(i.e., volumetric reconstruction model)으로 얻어지는 texture, shading, shape featrue 포함) 만으로도 객체의 물리적 파라미터를 복원하기에 충분한 정보를 제공한다는 것

- Young’s modulus(영률) & Poisson’s ratio(포아송비)같은 물성 예측

- 영률: 물체를 잡아당겼을 때, 얼마나 단단하게 버티는지를 나타내는 값(뻣뻣함의 정도)

- 포아송비: 물체를 잡아당겼을 때, 옆으로 얼마나 퍼지는지를 나타내는 값 (길게 늘릴 때 옆으로 줄어드는 비율)

- 3DGS같은 reconstruction model에 point-wise한 물질 추정을 같이 augment함

- CLIP visual prior 활용하고 physics solver에게 물체가 외부 요소(wind, gravity)에 의해 반응할 수 있도록 애니메이션 주입시키는 데에 사용함

- pixieverse 데이터를 제안해서 우리 모델 학습하는데 사용했음

- 여기서 $\mathcal{I}={I_k}_{k=1}^K $는 정적인 3D scene을 의미함

통합된 카메라 파라미터인 $\Pi$ 를 연속적인 3차원의 “material field” $\hat{\mathcal{M}}$로 매핑하는 것이 목표인 것

각 3차원 포인트 p는 아래의 재질 필드(material field)을 반환한다 \(\begin{align} \hat{\mathcal{M}} = \left( \hat{\mathcal{l}}(p),\; \hat{E}(p),\; \hat{\mathcal{v}}(p),\; \hat{\mathcal{d}}(p) \right) \end{align}\)

- 여기서 l은 이산적인 material의 종류를 나타내는 클래스가 무엇인지에 대한 거

E는 연속적인 영률(Young’s modulus), v는 포아송비, d는 밀도값을 각각 나타냄

- l: 이산적인 material의 종류를 나타내는 클래스 => “constitutive law(구성법칙)”로도 알려짐

- <Material Point Method>에 의하면, 이산적인 재료 클래스(즉, 구성 법칙)는 전문가가 정의한 초탄성 에너지 함수 $\mathcal{E}$와 리턴 매핑(return mapping, $\mathcal{P}$)의 조합으로 게산됨

- 이러한 point-mapping기반 방법은 fine-grained한 각 공간적 위치마다 물질의 재료 segmentation을 제공해줌

- 우리는 그래서 그 위치에 “semantic material label”과 함께 “physical parameter”를 같이 할당함

- 2D image 로부터 물성 바로 알기 쉽지않음, 따라서 우리는 “distilled feature field”를 활용해서 더 많은 visual prior를 표현할 수 있게 했음

- 또한 3D visual feature와 physical material사이의 매핑을 계산하기 위해 U-Net 아키텍처를 분리했음

3D Visual Feature Distilaltion

- CLIP같은 모델으로 dense 2D visual feature embedding이 뽑히는데, 이 피쳐를 3D로 lifting하여 volumetric representation으로 넘어가질 수 있음

- 전통적인 NeRF 표현을 사용하여 color와 density에 추가적으로 뷰에 상관없이 독립적인 feture vector를 에측한다 아래 식 참고.

- c랑 $\sigma$는 NeRF에서 나오는 아웃풋이고

- f는 high-dimensional descriptor, visual semantic을 포착함(물체의 정체성이나 또는 다른 특성들) => view-independent함

- RGB이미지의 color와 CLIP으로 뽑힌 2D visual feature를 pixel-wise supervised하여 학습

- 학습 이후, “scene bound”로 알려진 feature field를 그리드 $\mathcal{F}_G$로 복셀화시킨다 (차원=$N \times N \times N \times D$), which N=64 and D =768(Clip feature dim)

- 이 그리드가 “Material Network”의 인풋이 됨!

Material Grid Learning

- material learning network : $f_\mathcal{M}$는 feature projector $f_P$와 U-Net $f_U$로 구성되어 있음

(1) feature projector $f_P$: CLIP feature가 768차원으로 굉장히 high-dimensional하기 때문에, 이 고차원을 저차원으로 매핑해주는 역할- 3 layers of 3D convolution 네트워크

(2) U-Net architecture $f_U$: 투영된 feature Grid $\mathcal{F}_G$를 material grid $\hat{\mathcal{M}}(\mathcal{p})$로 매핑하는 것을 학습함 - material field인 $\hat{\mathcal{M}}$의 복셀화된 버전.

- 3 layers of 3D convolution 네트워크

</br> 위의 두가지 네트워크는 같이 end-to-end로 학습되고 cross-entropy와 mean-squared error loss를 이용해서 “이산적인 material classification”과 “연속적인 물성들(e.g., Young’s modulus & Poission value)”을 예측함

- 우리의 voxel griddml 98%는 배경부분으로 매우 sparse함

- 따라서 material netowrk $f_M$은 거의 대부분 배경만 예측하려고 할것이다

- 이러한 문제를 해결하기 위해서 “occupancy mask grid $\mathbb{M}$”을 계산함

- NeRF 표현의 “밀도 값”기준으로 thresholding($\alpha = 0.01$)해서 그 밑의 복셀들을 필터링하는 것

- 이렇게 필터링하고 남은 복셀들(occupied voxels)에서만 discrete cross-entropy와 continuous mean-sqaured error loss로 아래수식처럼 supervised learning시킴

- $N_{\text{occ}} = \sum_{p \in \mathcal{G}} \mathbb{M}(p)$ 는 그리드 내에서 \textit{점유된 복셀(occupied voxels)의 총 개수}를 의미하며, $\hat{\ell}(p)$ 와 $\ell^{GT}(p)$ 는 각각 예측된 재질 클래스 로짓(predicted material class logits)과 정답값(ground-truth)을 나타냄

- $CE$ : 크로스 엔트로피 손실(cross entropy loss), $\lambda$ 는 손실 가중치 계수(loss balancing factor)

- $E, \nu, d$ 는 각각 영률(Young’s modulus), 포아송비(Poisson’s ratio), 밀도(density) 값을 나타냄

Physics Simualtion

- MPM(Material Point Method)사용해서 물리 시뮬레이션 수행

- MPM solver는 point cloud를 인풋받아서 예측된 material field 속성을 보여줌 + 외부의 특수상황(e.g., wind & gravity) 시뮬레이션으로 변형과 이동

- NeRF 모델에서 입자(particle=> point cloud)를 샘플링하는 것이 가능하긴 하지만(예: 포아송 디스크 샘플링), 우리는 각 가우시안을 자연스럽게 MPM 입자로 간주할 수 있기 때문에 가우시안 스플래팅(Gaussian Splatting) 모델을 사용하는 것이 더 쉽다는 것을 발견함

- 따라서 자세(poses)가 주어진 다중 뷰 RGB 영상으로부터 별도로 가우시안 스플래팅 모델을 학습시킴

- 이후, 예측된 재질 그리드에서 얻은 재질 속성을 최근접 이웃 보간법(nearest neighbor interpolation)을 통해 가우시안 스플래팅 모델로 전이

- 그니까 재질 필드는 NeRF이용해서 학습하되, 마지막 시뮬레이션을 위해서만 가우시안 스픞래팅 모델 학습시키고 렌더링된거에서 재질 속성들만 “전이”하는 거임 (via nearest neighbor interpolation)

- 쥰나 비효율적이긴 한데 너프모델에서 물성예측이 더 잘 됐었나봄~

PixieVerse Dataset

- 데이터셋 얘기

Experiment

- Dataset: PixieVerse + evaluated on 38 합성 씬

- Simulation Details:

- MPM solver implementation from PhysGaussian

- Gaussian particle(입자) from Gaussian Splatting model

- External forces: gravity & wind

- Baselines

- DreamPhysics

- OmniPhysGS

- LLM method- NeRF2Physics

- DreamPhysics는 영률(Young’s modulus) 필드를 최적화하지만, 사용자에게 재질 ID(material ID), 포아송비(Poisson’s ratio), 밀도(density)와 같은 다른 값을 직접 지정하도록 요구함

- OmniPhysGS는 초탄성 에너지 밀도 함수(hyperelastic energy density function)와 리턴 매핑 모델(return mapping model)을 선택하며, 이 둘의 조합으로 필드 내 각 지점의 재질 ID가 결정됨, 다만 다른 물리 파라미터들은 여전히 수동으로 지정해야 함. => 두 방법 모두 ‘바람에 흔들리는 나무 그네(a tree swing in the wind)’와 같은 사용자 프롬프트와 생성형 비디오 확산 모델(generative video diffusion model)에 의존하여 모션 디스틸레이션 손실(motion distillation loss)을 최적화하는 메소드

- PIXIE는 모든 이산(discrete) 및 연속(continuous) 파라미터를 동시에 추론할 수 있음.

NeRF2Physics는 먼저 장면을 캡션으로 기술한 뒤, 대규모 언어 모델(LLM)에 질의하여 가능한 모든 재질 유형(예: ‘금속’)과 이에 대응하는 연속값을 얻는다. 이후 재질의 의미적 이름들은 CLIP 특징 필드 내의 3D 포인트와 연계되고, 물리적 속성들은 가중치가 부여된 유사도(weighted similarities)를 통해 할당됨

- Evaluation metrics

- Vision-Language mdoel Jude score(Gemini 2.5-Pro) => 물리 속성 잘 예측했는지 + 시뮬레이션 정성 평가

- 프롬프트 (어펜딕스 참고)로 0~5점 사이 평가매김

- PSNR & SSIM metric => reconstruction quality 정량 평가

- Vision-Language mdoel Jude score(Gemini 2.5-Pro) => 물리 속성 잘 예측했는지 + 시뮬레이션 정성 평가

This post is licensed under CC BY 4.0 by the author.